McAfee : rapport 2007 sur le typosquatting

Une étude confidentielle, menée conjointement par VeriSign et Zooknic en mars 2006, détaille les relations entre les noms des domaines enregistrés en .COM, .NET, .ORG et .TV (soit +90% des extensions génériques) et les mots clés qu'ils contiennent, selon un double axe d'analyse :

- la popularité des mots clés en nombre de recherches

- le prix de ces mots clés au PPC

Les plus demandés restant quoi qu'il en soit ceux qui caractérisent les activités plus communes sur le Web : la recherche, l'e-commerce, le divertissement (qui va de la musique aux films en passant par le sexe), les voyages, etc.

En outre, sur +3 000 mots clés et 25 millions de domaines analysés, il ressort que dans +94% des cas, les mots clés recherchés comprenant 1 seul terme se retrouvent dans les noms de domaine.

Voici les 20 premiers mots uniques et leur nombre d'occurrences respectives dans les noms de domaines (on retrouve plus ou moins les mêmes dans les 4 extensions analysées) :

Les termes à 2 mots caractérisent davantage le business (immobilier), la finance (crédits), la dimension locale et géographique (probablement liée à l'immobilier et aux vacances), les loisirs ou encore des phrases communes (on top, web sites, etc.) :

Idem pour les 3 mots :

Je rappelle que dans les tableaux ci-dessus, la colonne de gauche représente le classement de ces termes sur les 3000 analysés, et celle de droite le nombre de noms de domaines dans lesquels ils sont présents.

Par ailleurs, en sachant que l'étude a porté très exactement sur 25 049 980 domaines, ça permet de calculer les pourcentages pour les puristes. Exemple : "real estate" est présent dans 0,6% de l'échantillon.

À comparer avec les 20 mots que l'on retrouve le plus fréquemment mentionnés dans les brevets et marques américains :

- AMERICA(N)

- WORLD(S)

- COMPANY(IES)

- INTERNATIONAL

- HOME(S)

- NEW

- SYSTEM(S)

- LIFE(VES)

- SOLUTION(S)

- CENTER(S)

- BUSINESS(ES)

- PLUS

- POWER(S)

- NETWORK(S)

- SERVICE(S)

- GROUP(S)

- CLUB(S)

- HEALTH

- CARE(S)

- MANAGEMENT

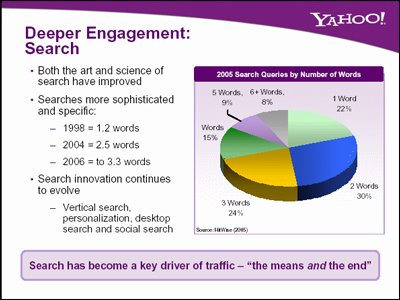

Autre relation que je vois, celle de l'augmentation du nombre de termes dans les noms de domaine, qui semble aller de pair avec l'augmentation du nombre de mots clés saisis dans les requêtes de recherche, dont la taille s'allonge au fil des ans : de 1,2 mot/requête en 1998 à 3,3 en 2006 selon Yahoo!

Idem pour les noms de domaine, puisque selon Bob Martin :

...the area of the market with the highest speculation and overheating are on names that are three or four words long.

... le secteur du (second) marché où la spéculation s'enflamme, c'est sur les domaines contenant 3 ou 4 mots clés. [Début]

* * *

Cet extrait est tiré d'un article intitulé Typo.com, qui nous permet ainsi une transition transparente vers le dernier point de cet article, la relation entre mots clés, noms de domaine et typosquatting.

Nous savons en effet que les mots clés sont au cœur d'un immense marché sur Internet, qui va des outils dédiés aux bidonneurs en tous genres, en passant du type-in au typo-in...

L'occasion m'en est donnée par la parution du rapport 2007 de McAfee sur l'état du typo-squatting, indiquant que selon une Agence gouvernementale américaine, 8,65% au moins de l'ensemble des domaines enregistrés le sont sous de faux noms ou avec des informations incomplètes, ce qui facilite les différentes pratiques de typo- et cyber-squatting.

Parmi les principaux résultats de l'étude (qui a analysé 1,9 million de variantes typographiques de 2 771 sites Web connus, en débusquant ainsi 127 381 personnes suspectées d'être des typo-squatters) :

- L'internaute lambda qui commet une erreur typographique de saisie a 1 chance sur 14 d'atterrir sur une URL typosquattée

- Les 5 catégories de sites les plus touchés sont les jeux (14,0%), les compagnies aériennes (11,4%), les principaux sites de média (10,8%), les sites porno (10,2%) et ceux liés aux technologies et au Web 2.0 (9,6%).

- Les sites d'enfants sont particulièrement ciblés par les typo squatters (sur MySpace également, plus de 60% des pubs affichées seraient "à risque")

- Idem pour les cyber-consommateurs

- Contrairement aux idées reçues, le taux de sites pornos parmi les sites typosquattés n'est que de 2,4%, en nette amélioration par rapport à de précédentes études

- L'usage croissant du domain tasting est un facteur significatif de la croissance rapide du typosquatting

- Hors États-Unis, les pays les plus touchés par ce phénomène sont le Royaume Uni (7,7%), le Portugal (6,5%), l'Espagne (5,9%), la France (5,4%) et l'Italie (4,1%) ; les moins touchés sont les Pays-Bas (1,5%), Israël (1,1%), le Danemark (1,0%), le Brésil (0,9%) et la Finlande (0,1%).

- Les cinq sociétés pratiquant le parking de domaines que préfèrent les typosquatters sont Information (28,5%), Hitfarm (11,3%), Domainsponsor (2,9%), Sedo (2,5%) et GoDaddy (2,3%) : le Top 5 représente 47,5% des squatters recensés par l'étude.

Voilà. L'étude est particulièrement fouillée, je vous y renvoie. Il y aurait encore beaucoup à dire sur tout ce qui précède, mais le billet est assez long comme ça, je crois que ça suffira pour aujourd'hui. :-) [Début]

Partager sur Facebook

Actualités, Domain tasting, typosquatting, Domain kiting, add-drop scheme, noms de domaine, Second marché, mots clés, Internet, McAfee

Actualités, Domain tasting, typosquatting, Domain kiting, add-drop scheme, noms de domaine, Second marché, mots clés, Internet, McAfee