Premier élément

Deuxième élément

1 + 1

* * *

Après plusieurs billets consacrés à GYM et un long intermède politique (une fois n'est pas coutume), je voudrais revenir sur un sujet que j'affectionne particulièrement : les noms de domaine.

J'ai déjà eu l'occasion d'expliquer comment fonctionne le second marché ou les taste-domaines, de parler de la longue traîne ou de l'ICANN, et surtout de montrer les abus et les rouages du business que font des acteurs tels que GoDaddy, eNom (également impliqué dans le désastre RegisterFly) ou Google, qui n'est pas le dernier puisqu'il joue sur tous les tableaux, notamment avec les AdSense (même si l'orientation pourrait changer, ce qui serait heureux).

Mais aujourd'hui je voudrais vous parler d'un risque. D'un danger, qui ... risque de nous tomber sur le coin du museau sans qu'on s'en aperçoive, et surtout sans que personne n'y trouve rien à redire une fois qu'on sera mis devant le fait accompli. Alors je préviens, c'est tout. Sans grande illusion puisqu'à mon corps défendant je vois ce

Mais commençons par le commencement, à savoir la navigation directe : le type-in traffic comme disent les anglo-saxons, c'est-à-dire la saisie directe du nom de domaine dans la barre d'adresse du navigateur, une alternative à la recherche sur les moteurs avec de meilleurs taux de conversion, ce qui semble d'ailleurs faire de l'ombre à Google.

Une alternative non négligeable puisqu'on évalue la fourchette des internautes qui naviguent de cette manière entre 10 et 15% du total. Donc lorsque l'on sait qu'au dernier trimestre 2006, Verisign a traité en moyenne 24 milliards de requêtes PAR JOUR uniquement sur les extensions .COM et .NET, ça peut donner une légère idée de ce dont on parle... (Voulez-vous que je répète ? : « VeriSign processed an average of 24 billion .com and .net queries per day in the fourth quarter of 2006... »

VeriSign, donc, qui est mieux placée que quiconque pour connaître les chiffres, a compris très tôt tous les bénéfices potentiels qu'elle pouvait tirer de la navigation directe, en introduisant dès 2003 le concept du SiteFinder, qui consistait à rediriger vers ses serveurs toutes les saisies de domaines inexistants en .COM et .NET (saisies erronées soit à cause de fautes de frappe soit parce que les domaines entrés n'étaient pas enregistrés). Ce fut un tollé général, davantage pour des questions liées à la vie privée des internautes que pour des questions techniques, et même si apparemment Verisign a perdu son procès, cette affaire est indirectement à l'origine du renouvellement par l'ICANN de son contrat de Registre agréé.

Or que se passe-t-il 4 ans plus tard (SiteFinder remonte à sept.-oct. 2003) ? Dans les principaux contrats d'agrément signés avec les registres, l'ICANN a introduit une clause (je ne les ai pas tous vérifiés, mais elle est présente pour les extensions .ORG, .BIZ, .INFO), généralement à la Section 3.1(f) de l'ARTICLE III (Covenants), intitulée Traffic Data, qui dit exactement ceci :

Nothing in this Agreement shall preclude Registry Operator from making commercial use of, or collecting, traffic data regarding domain names or non-existent domain names for purposes such as, without limitation, ...Maintenant, pour ce qui concerne Verisign, si la clause n'est pas présente pour le .NET, elle est bel et bien là pour le .COM, l'ICANN se montrant encore plus explicite :

(...)

Nothing contained in this section 3.1(f) shall be deemed to constitute consent or acquiescence by ICANN to an introduction by Registry Operator of a service employing a universal wildcard function.

Traduction

Rien dans cet accord n'empêche le Registre de collecter ou d'exploiter commercialement les données statistiques concernant le trafic des noms de domaine existants OU NON, à des fins, sans que la liste soit exhaustive...

(...)

Aucune des dispositions de la présente section 3.1(f) ne sera réputée impliquer le consentement ou l'acquiescement de l'ICANN à l'introduction par l'opérateur du Registre d'un service employant une fonctionnalité de jocker universel.

Nothing contained in this section 3.1(f) shall be deemed to constitute consent or acquiescence by ICANN to a re-introduction by Registry Operator of the SiteFinder service previously introduced by the Registry Operator on or about September 15, 2003, or the introduction of any substantially similar service employing a universal wildcard function intended to achieve the same or substantially similar effect as the SiteFinder service.Donc, au plan légal, la question que je me (vous) pose est celle-ci : « Quelle est la portée juridique de cette phrase (Aucune des dispositions de la présente section 3.1(f) ne sera réputée impliquer le consentement ou l'acquiescement de l'ICANN...) ? »

Aucune des dispositions de la présente section 3.1(f) ne sera réputée impliquer le consentement ou l'acquiescement de l'ICANN à la réintroduction par l'opérateur du Registre du service SiteFinder, précédemment introduit par ce même opérateur aux alentours du 15 septembre 2003, ni à l'introduction d'un service sensiblement identique employant une fonctionnalité de jocker universel, qui aurait des buts et des effets sensiblement identiques à ceux du service SiteFinder.

Je ne suis pas spécialiste du droit des noms de domaine, mais si les mots veulent dire ce qu'ils disent, ça signifie tout simplement que l'ICANN n'entend pas cautionner cette pratique, sans l'interdire formellement pour autant...

C'est le premier élément. Passons au second. [Début]

* * *

Les ccTLDs (Country Code Top-Level Domains) sont les extensions correspondant aux codes pays, dont l'utilisation est en hausse constante (voir les stats). Selon Verisign, fin 2006 on comptait 43,7 millions de domaines enregistrés en codes pays (soit une augmentation de 31% par rapport à fin 2005), dont plus de quatre millions enregistrés durant le dernier trimestre 2006 (soit 10% de mieux que le trimestre précédent. L'extension la plus en vogue est le .cn (Chine), tandis que 42 autres codes pays connaissent un taux de progression à deux chiffres, dont le .se (Suède), .es (Espagne), .ru (Russie), .at (Autriche).

2006 ended with 43.7 million ccTLDs, a 31 percent increase over the end of 2005. Just over four million ccTLDs were added in the fourth quarter of 2006, a 10 percent growth over the third quarter. This is the largest quarterly growth for ccTLDs. The growth seems to be driven in large part by .cn (China) which added more than 500,000 names in the fourth quarter alone, a 43 percent increase quarter over quarter. While China made a large impact, the growth was widespread with fifty-two ccTLDs experiencing double-digit growth including .se (Sweden), .es (Spain), .ru (Russia) and .at (Austria).

En outre, comme le reconnaît l'ICANN, les relations avec les opérateurs des registres pays sont plus complexes à gérer (These relationships are more complex, because of the varying circumstances ... of different ccTLDs and the organizations that operate them).

Prenons l'exemple du Cameroun (.cm) et de Kevin Ham, fondateur de Reinvent Technology (plus ici).

En exploitant un brevet déposé par Robert Seeman en 2006, n° 20060053213, intitulé « Method of handling web page requests from a browser » (Méthode de traitement des requêtes d'affichage d'une page Web à partir d'un navigateur), Kevin Ham a passé un accord avec le premier ministre de ce pays, Monsieur Ephraïm Inoni, de sorte que tous les type-ins ayant une extension .cm saisis par les internautes finissent sur un site, Agoga.com, qui compte actuellement la bagatelle de ... 8 millions de visiteurs uniques par mois ! Si Adscriptor faisait ça, je crois que je mettrais des Adsense dessus. :-)

Essayez cette requête, vous verrez que les pubs sont servies par ... Yahoo! Qui n'a pas commis l'erreur de Google, de ne pas enregistrer son extension en .cm (la redirection de Google.cm sur un autre site qu'Agoga étant due uniquement au souci de M. Ham d'éviter quelque casse-tête juridique...).

Mais le brevet va plus loin, puisque s'il mentionne expressément les cinq extensions qui sont des typos des .COM et .NET [".cm" (Cameroun), ".om" (Oman), ".co" (Colombie Britannique), ".ne" (Niger) et ".et" (Éthiopie)], il est beaucoup plus générique dans ses revendications (1. A method of handling a request from a browser for a web page with a given TLD that an end-user has entered into the browser URL line, comprising the steps of: (a) determining whether the URL defines a web page that exists for that TLD; (b) if it does not exist, then providing for a domain name server to automatically direct the browser to at least one web site and not provide an error message; characterised in that the TLD has been erroneously entered by the end-user as a ccTLD instead of a TLD selected from the set of .com and .net TLDs.)... [Début]

* * *

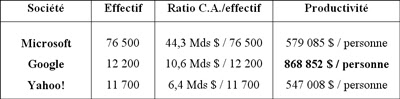

Une info qui va faire son petit bonhomme de chemin puisqu'elle a été relayée avant-hier par Michael Arrington lui-même et reprise sur Techcrunch France, où elle est donnée brute...

J'espère donc que la présente analyse vous permettra d'y voir plus clair, ma principale crainte étant qu'en faisant 1 + 1 on puisse un jour se retrouver avec un certain nombre de registres qui mettront en œuvre ce genre de pratiques, sans que rien ne puisse légalement les en empêcher.

Mais bon, je me trompe peut-être. Du moins je l'espère. [Début]

Actualités, Google, navigation directe, type-in, type-ins, noms de domaine, ICANN, Internet

Actualités, Google, navigation directe, type-in, type-ins, noms de domaine, ICANN, Internet