Noms de domaine et parking : Parking 2.0 vs. Parking 1.0

Parking 1.0 : déclin d'un modèle économique qui s'essouffle

Parking 2.0 : évolution du parking et nouveaux modèles économiques

* * *

Parking 1.0 : déclin d'un modèle économique qui s'essouffle

Il y a longtemps que je voulais faire un billet sur la nature et l'évolution du parking. En France, les gens ont tendance à liquider ça d'un revers de main, en criant bien haut et fort comme quoi c'est indécent, et ceci et cela. Et puis le parking c'est du cybersquatting, et du typosquatting, et du phishing, et ceci et cela.

Mais point de discussions véritablement sérieuses, à part

sur Blogodomaines, mais c'est normal, me direz-vous, puisqu'il est partie prenante. Il n'empêche, ce n'est pas parce qu'on est partie prenante qu'on écrit forcément des choses intelligentes comme l'ami Rémy.

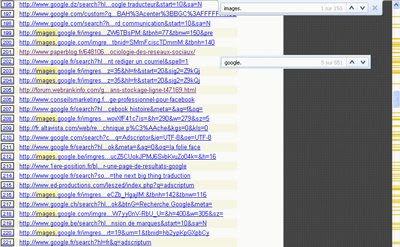

Qui nous fournit d'ailleurs une bonne illustration de comment fonctionnent actuellement le parking et le modèle économique qu'il y a derrière :

Un modèle économique aujourd'hui fortement en crise, nous allons voir pourquoi. Mais en tout état de cause, continuer à l'infini de faire l'impasse sur une réalité économique faite d'

une vingtaine de millions de sites témoigne d'une absence totale de clairvoyance...

Tout d'abord je vais laisser de côté l'internaute et l'annonceur, même s'ils font clairement partie intégrante de l'écosystème "parking", pour me concentrer sur les trois types d'acteurs généralement impliqués :

- la régie publicitaire

- la plateforme de parking

- le titulaire du nom de domaine

1. La régie sert les pubs, c'est-à-dire qu'elle fournit les liens contextuels et/ou, plus rarement les bannières ;

2. la plateforme de parking héberge ces liens sur une page Web, vers laquelle pointe le nom de domaine ;

3. les titulaires de noms de domaine en parking ont un profil extrêmement segmenté, allant du simple particulier avec un seul ou quelques noms parqués, aux registrars du genre

Moniker ou Fabulous & Co. qui peuvent gérer directement ou indirectement plusieurs millions de noms, en passant par des portefeuilles intermédiaires de quelques centaines à des milliers de noms, ou plus importants en quantité (

Frank Schilling) (

plus de 100 000 domaines) et/ou en valeur (

Rick Schwartz) (+5 000, dont

Candy.com, Properties.com, Tradeshows.com, Cheating.com, etc.).

Les registrars comme

GoDaddy ou

Domainsite (pour ne citer qu'eux) sont des cas à part, même s'ils ont en commun d'exploiter le parking en partenariat avec Google.

Or jusqu'à présent, la logique économique consistait essentiellement à cibler la pertinence des liens contextuels en fonction du nom de domaine et de son potentiel en navigation directe.

Mais bon, comme je l'expliquais

ici, il n'y a qu'un seul nasa.com, ou

meteo.com..., et par conséquent cette logique a trouvé ses limites, notamment à cause de la convergence de plusieurs facteurs :

- la pratique de la navigation directe, dont les revenus étaient généralement estimés à 10-15% de l'ensemble des revenus générés par la recherche payante (chiffre encore à vérifier, si quelqu'un a des infos), est en perte de vitesse constante, au profit de la recherche directement dans les moteurs de recherche, un concept encore affiné avec la onebox de Chrome ;

- la désaffection des internautes, de plus en plus las d'atterrir sur des pages poubelles truffées de liens publicitaires qui n'apportent désormais plus aucune valeur ajoutée à leur "expérience utilisateur" (sans parler des craintes implicites du genre : est-ce que je ne vais pas attraper un virus si je clique sur un de ces liens, etc.) ;

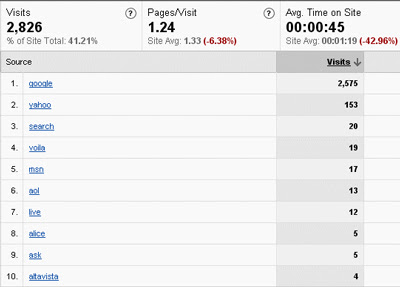

- les grosses régies qui étaient les principaux pourvoyeurs de fonds des parkings - j'ai nommé Google et Yahoo! - changent lentement mais sûrement leur fusil d'épaule, Google en ouvrant à tous son programme AdSense for Domains, en rupture totale comme à son habitude, et Yahoo! en faisant n'importe quoi, comme à son habitude...

Résultat des courses : une

baisse considérable des gains par clic (EPC - Earnings per click).

Quant aux prestataires de parking,

comme l'explique Rémy, leur but ultime consistait à «

agréger le plus de trafic possible pour pouvoir négocier des contrats plus intéressants avec les fournisseurs de liens publicitaires. Et ce pour pouvoir à (leur) tour offrir des taux de rémunérations toujours plus compétitifs à (leurs) clients. Et agréger encore plus de trafic (effet boule de neige) », voire à «

se lancer eux-mêmes sur l’enregistrement et le rachat de noms de domaine pour s’assurer une taille critique ».

Donc maintenant que toutes les logiques qui ont assuré le succès de l'ère Parking 1.0 sont définitivement cassées, il serait peut-être temps de passer à l'ère Parking 2.0. Voyons comment.

[Début]

* * *

Parking 2.0 : évolution du parking et nouveaux modèles économiques

La première réflexion est qu'une constante demeure entre les concepts de Parking 1.0 et Parking 2.0, à savoir que

le parking reste un fort vecteur publicitaire, un formidable canal promotionnel pour peu qu'il soit ciblé et pertinent.

Les annonceurs et les régies ont accepté le parking tant qu'ils en jugeaient le trafic qualifié, traditionnellement avec des taux de conversion des pages parking jugés supérieurs à ceux des clics sur les moteurs de recherche (

4,23% vs. 2,3%, selon une étude WebSideStory -

Omniture aujourd'hui - qui a fait date).

Pour autant, le deuxième constat, c'est que

l'ensemble de l'écosystème Parking 1.0 a été construit autour d'un grand absent : le CONTENU !

Or même si le parking est souvent une situation intermédiaire, qui permet de générer des revenus dans l'attente d'une revente, ça n'est pas une excuse pour faire n'importe quoi entre-temps. D'où la confusion de plus en plus justifiée entre les pages parking et les MFA (Made for Adsense), vu que pendant longtemps

Google n'a pas vraiment fait grand chose pour corriger ses incohérences...

D'où également la connotation de plus en plus négative du parking, associé à du parasitage pur et simple par une grande partie du public francophone. L'approche des anglo-saxons est différente, comme souvent sur Internet, ce qui n'empêche que les internautes se retrouvant sur ces pages sont de moins en moins considérés "qualifiés" par les annonceurs, qui font également l'amalgame avec la fraude aux clics.

Une situation critique qui demande un renversement de tendance net. Comment ?

En inversant la traîne, tout simplement, c'est-à-dire en passant de la longue traîne à la grande traîne de l'UGC :

- en insufflant du contenu dans le parking, et si possible du contenu pertinent, de qualité ;

- en rémunérant enfin les créateurs de ce contenu à travers un partage des revenus plus favorable.

Fini les

vieux critères de partage, tout le monde y trouverait son compte. Des internautes aux annonceurs...

D'où

une nouvelle définition du parking, qui m'a été soufflée par

Jean-Philippe Hermand :

crédibiliser les liens publicitaires par la pertinence du contenu.

On constate d'ailleurs un désir de diversification de plus en plus poussé chez des acteurs établis du parking, qui commencent à tourner autour de ces concepts, que ce soit celui de la pertinence via la sémantique (approche de

SEDO qui investit dans Domainsbot), ou celui du contenu via le développement de véritables minisites (démarche de

AEIOU,

Kwikcontent,

WhyPark ou

Parking Revolution, entre autres).

Mon idée est différente. Pour moi, le bon mix consisterait à

alimenter automatiquement les pages parking en flux RSS pertinents par rapport aux noms de domaine, sur le modèle

Wikio de catégorisation thématique et de création de pages à la volée (ce que fait également fort bien

Webjam).

Imaginez que chaque blogueur choisisse en opt-in que ses flux soient repris sur des parkings, naturellement

contre un partage de revenus équitable entre les différentes composantes : la régie, l'agrégateur-distributeur de flux, les créateurs des contenus syndiqués et les titulaires des noms de domaine !

Coup double : une

source de monétisation supplémentaire pour les créateurs de contenu d'une part, un

flux ininterrompu d'UGC alimentant en automatique des pages parking complètement révolutionnées de l'autre.

Les spécialistes de l'AdSense pourraient objecter que si le contenu est trop pertinent, les internautes cliqueront moins sur les pubs. Soit. Mais de toutes façons, avec les formules actuelles, ils ne cliquent plus dessus de toute façon. À tel point que tout le monde - des annonceurs aux régies en passant par les utilisateurs - ne demande plus qu'une chose : de la qualité !

C'est le concept de

smart pricing chez Google :

Ajoutez toujours plus de contenu pertinent à votre site et maintenez-le à jour afin de conserver l’intérêt de vos visiteurs. Si vos visiteurs sont intéressés par vos pages et qu’ils cliquent sur l’une de vos annonces, ils effectueront probablement une action sur le site de l’annonceur partenaire et votre taux de conversion s’en verra augmenter, de même que vos revenus. Du contenu de qualité se traduit souvent par une expérience positive pour vos visiteurs et vos annonceurs.

Donc s'il est vrai qu'il n'y a plus de qualité sans contenu pertinent fréquemment réactualisé, il est tout aussi vrai que

personne n'a encore trouvé le moyen d'alimenter en temps réel des centaines de milliers - voire des millions - de sites parking en contenu de qualité.

Ce que pourrait assez facilement faire une plateforme comme

Wikio, j'en ai déjà parlé avec Pierre Chappaz il y a plusieurs mois, mais il ne m'a pas semblé convaincu. D'où ma décision de partager mes idées avec la "communauté", juste pour tester le retour et collecter vos critiques et suggestions.

Au départ, me semble-t-il, c'était un peu l'idée de

Blogbang, qui a pourtant réussi à casser dans la foulée une dynamique particulièrement porteuse, en merdant totalement le back-office après un démarrage en trombe. Dommage ! Et difficile à rattraper. Même si avoir

Publicis derrière, ça peut aider...

Quant à cette (r)évolution des pages parking, il faut qu'elle n'ait pas seulement lieu sur le fond (le contenu), mais aussi sur la forme, en allant plus loin que la logique Google (

depuis longtemps, et

plus que jamais, dans le business...) :

En calquant la conception de ces pages sur le modèle des

(r)évolutions qui attendent les traditionnelles pages de résultats, par exemple, encore «

aujourd'hui TRÈS largement sous-exploitées, en termes de présence optimisée : - par les images

- par les vidéos

- par les cartographies

- par les médias sociaux

- par les widgets

- multiforme et multiformats (blogs, sites, pages de réseaux sociaux, sites de partages de favoris, de documents...)

- par la publicité

Etc. »

Mais ce sera un autre débat ... dont j'espère qu'il aura lieu !

[Début]

Partager sur Facebook

Actualités

Actualités,

parking,

parking 1.0,

parking 2.0,

noms de domaine,

positionnement,

référencement,

optimisation,

contenu,

SEO,

SEM,

mots clés,

pages clés,

keywords,

keypages,

moteurs de recherche,

moteurs

Actualités, Google, positionnement, référencement, optimisation, contenu, SEO, SEM, mots clés, pages clés, keywords, keypages, moteurs de recherche, moteurs

Actualités, Google, positionnement, référencement, optimisation, contenu, SEO, SEM, mots clés, pages clés, keywords, keypages, moteurs de recherche, moteurs