7 conseils pour vous positionner dans la première page de résultats de GooglePrise de conscience et commentaire de

Tom :

Sacré référencement !

chapeau bas d'un SEO ;)

Ma réplique :

Merci pour ton commentaire, je crois que j'y répondrai par un billet...

Chose dont se réjouissais

Jean-François, pour «

lire (m)on avis sur les efforts de référencement que ce joli résultat implique ! :-) »

Dont acte.

En replaçant d'abord les différents événements dans leur contexte.

* * *

Depuis le

début de ce blog jusqu'à fin septembre 2007, je n'ai abordé Facebook que de manière indirecte, à 4 reprises :

- le 2 août à propos de Netvibes

- le 17 sur le widget Where I've been

- les 25 et 26 septembre, en parlant de Microsoft

Puis, le 7 octobre, j'ai publié le premier billet intégralement dédié à

Facebook et son décalogue, suivi le lendemain d'une

version anglaise, juste histoire de rassembler mes idées sur la question.

Le même jour, le 8 octobre donc, j'ai rédigé ce que je considère comme mon véritable premier article sur la société de Mark Zuckerberg, tout simplement intitulé

Facebook.

C'est ce billet qui sort en

première page des résultats de Google, depuis environ deux semaines.

Ce qui signifie qu'en un mois, un billet parti de rien, pratiquement sans aucun background sur l'argument, exception faite pour quelques rares billets traitant la question de façon plutôt indirecte et superficielle, réussit à se placer dans les dix premiers sur des dizaines de millions de résultats, et ce sur la requête la plus "chaude" du moment. Comment est-ce possible ?

Comme je le disais à

Jean-François, j'ai ma petite idée, rien d'empirique, tout juste quelques intuitions.

[Début]* * *

Primo, il faut se souvenir que depuis le mois de mai dernier, date à laquelle Zuckerberg a ouvert son réseau aux développeurs, la rumeur autour de Facebook est allée crescendo.

Donc la première question que je me suis posée a été "et maintenant, que pourrais-je dire de nouveau sans ressasser toujours les mêmes choses" ?

Que dire d'original sur un sujet pour lequel tous les médias - Internet, presse, télé, radio - font de la surenchère d'information, pas toujours de qualité il est vrai, puisqu'ils ont souvent tendance à simplifier à outrance, comme s'ils s'adressaient à des débiles.

Par conséquent, mon premier but a consisté à créer du contenu original et de qualité pour tenter d'expliquer, d'abord à moi-même, le phénomène Facebook. Où je me suis inscrit pour avoir une vision "de l'intérieur".

Mon billet a été

diversement apprécié, voir entre autres le commentaire de

Rod le hibou :

Enorme jeviens d’aller voir l’analyse … donc en gros (huhu), faut ecrire 30 pages Word pour comprendre l’interet de Facebook et savoir l’utiliser : à quand la sortie de “Facebook pour les nuls ?” … le web 2.0 = simplicité les enfants, pas des dissertations pour comprendre l’utilité d’un projet. 31 ans que je vis sans Facebook, et je vivrai sans sans souci. Pour certains c’est une question de vie ou de mort : nickel. Chacun doit trouver son but dans la vie. Mais de la à écrire des pamphlets explicatifs, faut vraiment avoir rien à foutre :)

Sic ! Chacun ses opinions, n'est-ce pas ?

Donc,

contenu original et de qualité, premier point.

Deuxième point : ce n'est pas un billet isolé.Dans la foulée j'en ai écrit 25 autres, 19 en octobre et 6 en novembre jusqu'à aujourd'hui, celui-ci exclu, dont 16 qui ont Facebook pour argument principal, et 9 où il en est question de manière plus ou moins directe.

Ajoutés à ceux qui les ont précédés, cela fait un ensemble de

30 billets écrits en deux mois. Non pas 30 pages, comme se désespère Rod le Hibou, mais 30 billets de 30 pages :-)

Sur le même sujet ! Il faut dire aussi que je suis long à comprendre... Et vu que j'ai rien à foutre, au moins j'ai trouvé de quoi occuper mes journées. Tout s'explique.

Pour autant ce deuxième point implique deux critères essentiels :

1) fréquence de publication,

2) création d'une taille critique.Sur le 1), nous savons que Google a horreur des sites statiques, et les blogs sont parfaits pour créer un contenu dynamique. Sur le 2), j'entends par "taille critique" le fait de générer une information abondante (où la qualité va de pair avec la quantité, c'est clair) autour d'un argument donné.

Pas facile de quantifier précisément cette "taille critique", puisque de toute façon seuls Google et ses algorithmes la connaissent, et de plus elle doit varier en fonction des sujets, du moment, des circonstances, et d'une série d'autres critères impossibles à déterminer (tout au moins pour moi).

Pour être générique, disons que la masse d'information doit être suffisante pour cerner le sujet avec un seuil minimal de pertinence et d'exhaustivité.

Dernier point : être en phase avec l'actualité.

Chose probablement plus facile avec un blog qu'avec un site, puisque les blogueurs sont immanquablement sollicités et inspirés par les événements qui passent à leur portée, en ligne ou hors ligne.

L'idéal serait même d'

anticiper cette actualité, voire de se livrer parfois à quelques exercices de

prospective ou de

mise en perspective.

À défaut, il est primordial de savoir

rebondir, vite : la réactivité à l'info est cruciale. Il m'arrive souvent d'écrire dans l'urgence car je sais que l'occasion perdue est difficilement rattrapable. C'est d'ailleurs davantage une contrainte qu'un plaisir, mais qui a dit que bloguer était de tout repos ?

Ceci explique pourquoi en ce moment

Facebook est mon premier sujet d'actualité !

Comme vous le voyez sur cette capture d'écran, les 622 réactions sont les liens retours calculés à ce jour par

Technorati, en sachant que

seuls les six derniers mois sont pris en compte.

Même si à vrai dire ce décompte varie considérablement avec celui de Google, qui répertorie plusieurs centaines de liens uniquement sur les billets que j'ai consacrés à Facebook au mois d'octobre.

Autant de facteurs conjugués qui expliqueraient pourquoi Adscriptor ressort si bien dans Google sur la requête "Facebook".

Car les

rétroliens sont encore et toujours pour le PageRank l'un des plus importants critères afin d'

optimiser son positionnement dans les pages de résultats de Google.

Ainsi, pour les 309 billets rédigés à ce jour, celui-ci inclu, Google répertorie globalement

17229 liens qui pointent vers les billets d'Adscriptor, dont 8559 vers la page d'accueil.

En conclusion, pour résumer cette première étape :

La production d'une info originale et de qualité (je me jette des fleurs, mais comme on dit, on n'est jamais aussi bien servi que par soi-même ;-), fraîche - c'est-à-dire en phase avec l'actu, fréquemment mise à jour -, et en quantité suffisante, a souvent pour conséquence la création de nombreux backlinks.

[Début]* * *

Mais ce n'est qu'un début. Car c'est là qu'entrent en jeu au moins deux autres critères attentivement pondérés par les algorithmes de Google, qui évaluent en permanence les pages indexées :

1. le taux de clic

2. le taux de rebondLe premier est ainsi

défini :

le nombre de fois où un lien est cliqué par rapport au nombre de fois où ce lien est affiché. Or il est évident que plus un lien est bien positionné, plus il sera cliqué...

Et grâce à l'outil de

Google pour les Webmasters, je sais que mon taux de clics est élevé, puisque sur la requête "Facebook", qui représente

94% de mon taux d'affichage, le lien est cliqué dans

89% des cas !

Ensuite, une fois le lien cliqué, intervient le taux de rebond, ou

bounce factor, que je vais m'efforcer d'expliquer sans m'enfoncer dans des détails techniques.

Si vous avez installé

Google Webmasters Tools et/ou

Google analytics sur votre blog/site, vous comprendrez facilement ô combien Google dispose de stats détaillées sur le comportement de vos visiteurs en général, et sur le vôtre en particulier...

Par exemple, en calculant du 25 septembre au 22 novembre, laps de temps qui contient pratiquement tous mes billets sur Facebook, Adscriptor totalise en deux mois 44967 pages vues, dont 19916 se réfèrent - sur les 10 premières URL visitées - aux 4 billets les plus lus sur Facebook (entre parenthèses, le temps moyen passé sur la page par visiteur) :

Facebook (2'22'')

Facebook : le décalogue ! (3'38'')

Facebook annonce Facebook Ads (3'45'')

La pub sur Facebook : Google Adsense ? (3'51'')

Pour un total de 13'36'' sur 4 pages, soit

une moyenne de 3 minutes 24 secondes par page.

Or là nous touchons à un point crucial, à savoir le dilemme "

faire court vs. faire long" sur un blog. En général, la majorité des marketers

préconisent des billets courts (

Veillez à ne pas dépasser 250 mots par message), mais selon moi c'est oublier un peu vite que nous écrivons

AUSSI pour les moteurs.

Puisqu'il est évident que plus les billets sont courts, moins les internautes ont de quoi lire (moins les moteurs ont de quoi indexer), et plus ils repartent vite. D'où un taux de rebond beaucoup plus important qu’avec des billets longs. CQFD !

À mon avis, ceci a également des conséquences sur le taux de sortie, puisque moins un internaute a de probabilités de touver l'info qui l'intéresse, plus il y a de chances pour qu'il reparte vite de votre site.

Enfin, n'oublions pas que chaque blog s'inscrit dans

un réseau sémantique propre, à la fois par ses liens externes (de/vers les autres) et internes, autant par ses connexions entre les billets que par les liens internes au sein d’un même billet, le tout ayant pour but de faciliter la navigation.

Dans mon cas,

Google Webmasters Tools recense

7905 liens internes pour Adscriptor.

Dans la blogosphère, le premier exemple semblable qui me vient à l'esprit est celui de

Didier Durand, où pratiquement chaque billet renvoie à d'autres de ses billets, dans un maillage qui fait du blog un tout, englobant des billets non pas isolés - qui seraient sans rapport les uns avec les autres -, mais étroitement connectés.

Last but not least, dans le cas du billet

Facebook, il y a cohérence parfaite entre l'URL de l'article et son objet, or nous avons vu que le fait d'inclure

un mot clé dans un nom de domaine confère un facteur de pertinence fort au domaine (ou à l'URL dans le cas présent).

En conclusion, les internautes attentifs auront noté que je n'ai pas encore mentionné le PageRank. Non pas parce qu'il n'a pas d'importance (je suis

convaincu du contraire), mais parce que mon blog a un PR 5 et que cela n'est qu'une goutte d'eau incapable de justifier la présence d'une URL en première page de résultats sur Google.

Au final, pour récapituler mes intuitions, je vais vous la jouer style gourou marketing anglo-saxon (un pléonasme...), dans le genre «

7 conseils pour vous positionner dans la première page de résultats de Google sur une requête donnée » :

- Générer un contenu original et de qualité

- Proposer une information fraîche, fréquemment mise à jour

- Coller à l'actu, l'anticiper si possible, être réactif

- Produire en quantité suffisante

- Lier généreusement vers les autres et capitaliser sur les liens retours

- Ne pas craindre de rédiger des billets longs pour favoriser les taux de clic et de rebond

- Inclure les mots clés dans les URL

Tels sont les critères, je pense, qui ont favorisé le positionnement d'Adscriptor sur la requête

Facebook dans Google.

[Début]Partager sur FacebookP.S. Tout ce qui précède est un exemple parfait de ce que j'appelle depuis

longtemps ma théorie sur le référencement/ positionnement par le contenu pur...

Actualités

Actualités,

Facebook,

statistiques,

Google,

positionnement,

référencement,

optimisation,

contenu,

SEO,

SEM

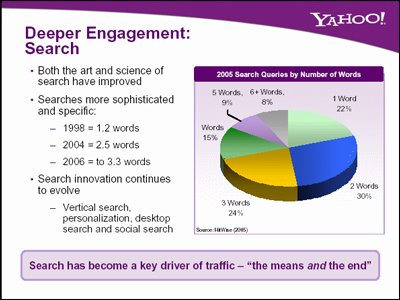

En outre elle fait apparaître un déplacement vers de nouvelles formes d'implications qui gagnent en importance au fil des semaines, à savoir les réseaux sociaux et le contenu généré par l'utilisateur (UGC), avec un taux de contribution croissant qui va bientôt reléguer la règle des 1% au rang des antiquités.

En outre elle fait apparaître un déplacement vers de nouvelles formes d'implications qui gagnent en importance au fil des semaines, à savoir les réseaux sociaux et le contenu généré par l'utilisateur (UGC), avec un taux de contribution croissant qui va bientôt reléguer la règle des 1% au rang des antiquités.

Actualités, marché publicitaire, publicité, pub, médias sociaux, réseaux sociaux, UGC, contenu, IBM, Internet

Actualités, marché publicitaire, publicité, pub, médias sociaux, réseaux sociaux, UGC, contenu, IBM, Internet